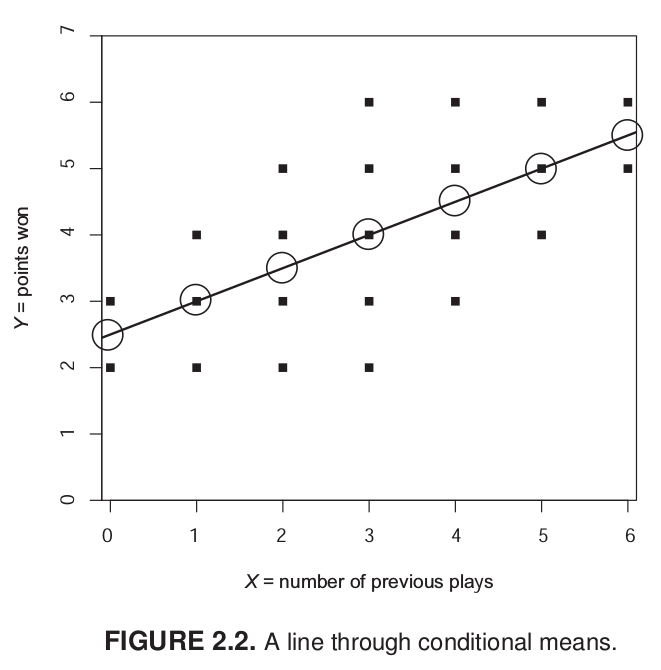

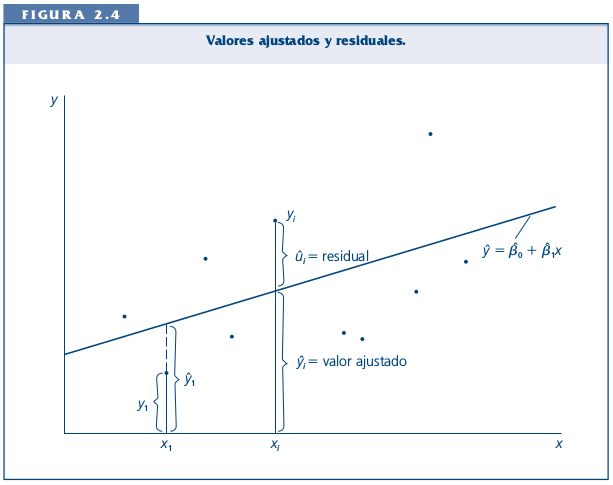

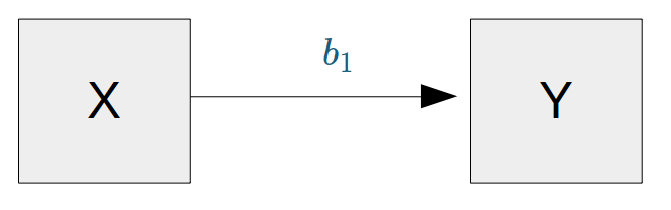

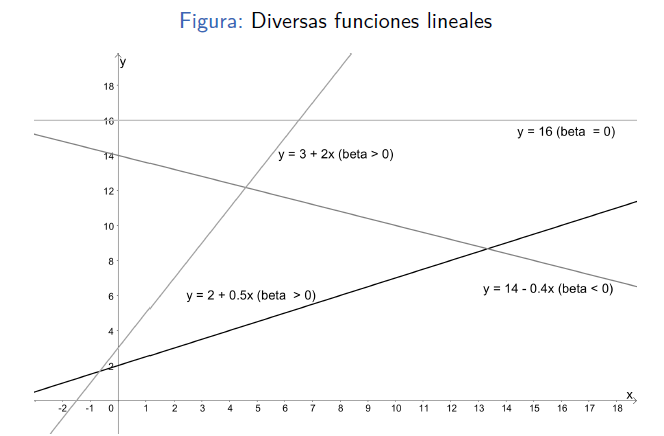

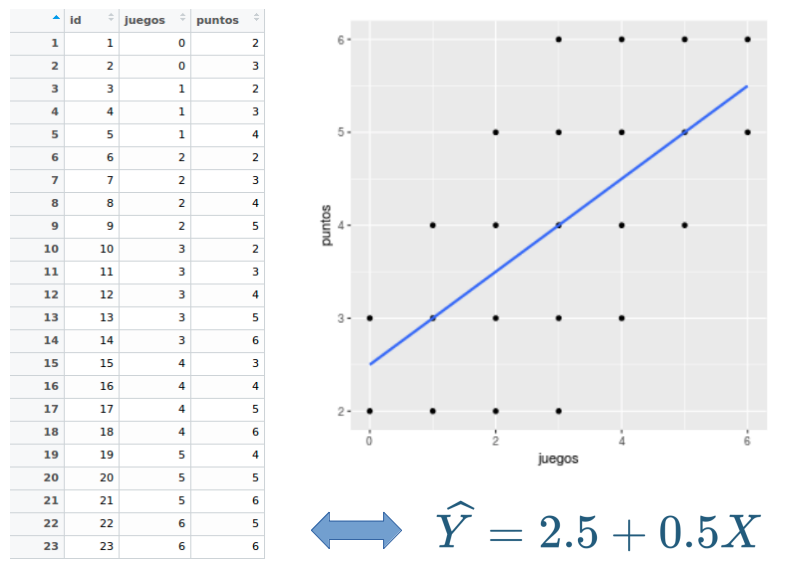

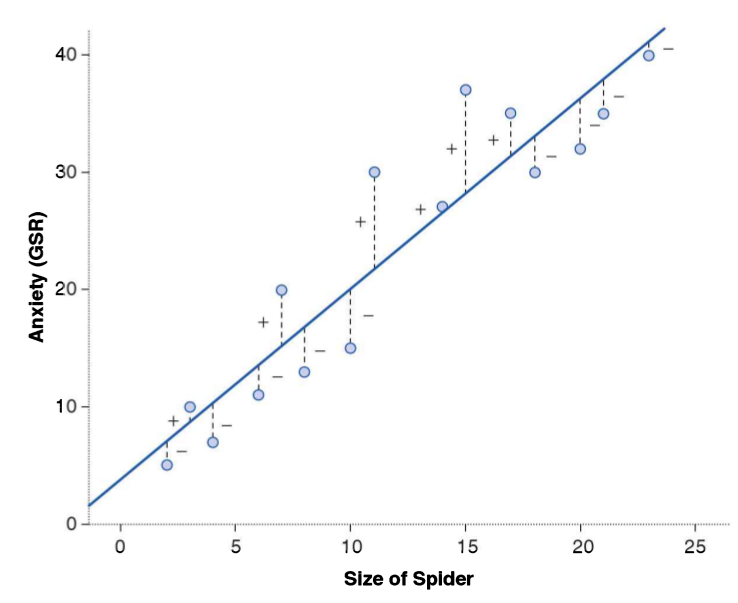

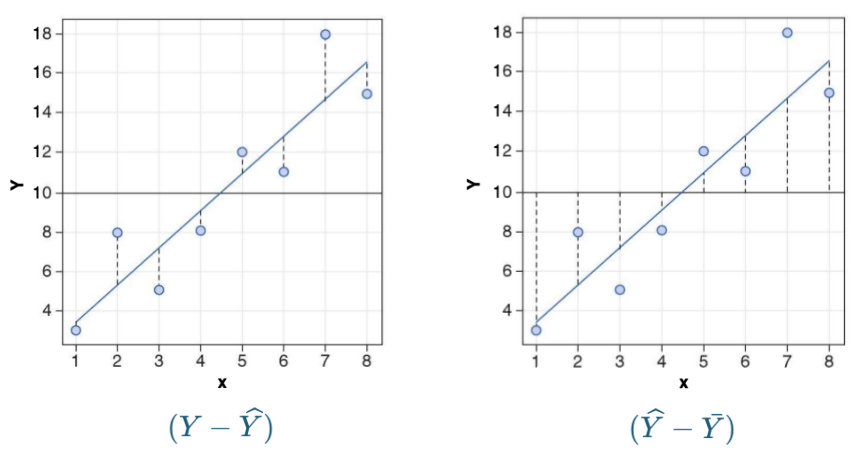

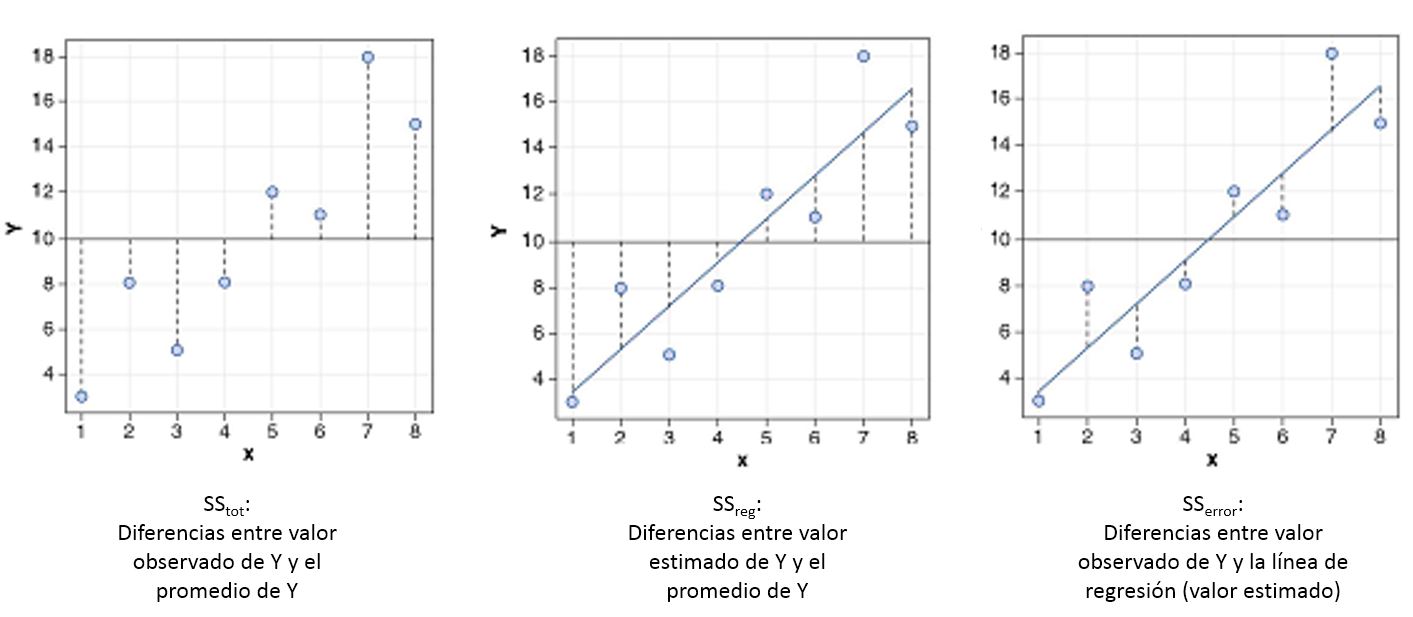

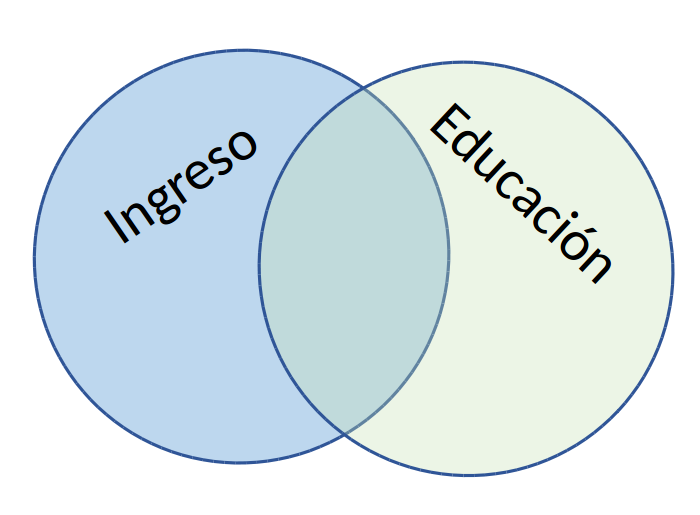

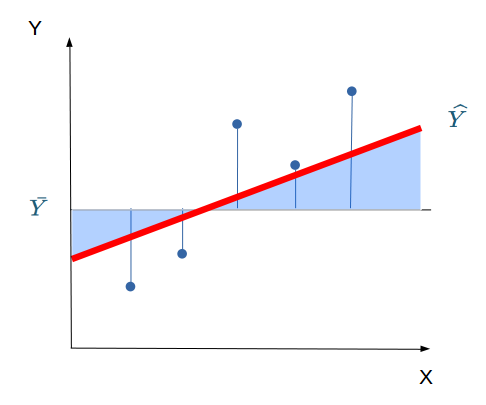

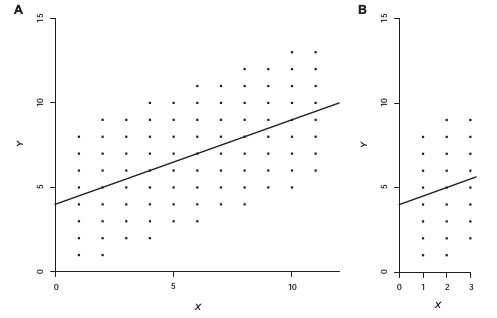

class: bottom, left <!--- Para correr en ATOM - open terminal, abrir R (simplemente, R y enter) - rmarkdown::render('4_regsimp2.Rmd', 'xaringan::moon_reader') About macros.js: permite escalar las imágenes como [scale 50%](path to image), hay si que grabar ese archivo js en el directorio. ---> .right[] <br> <br> <br> <br> <br> <br> <br> # Estadística multivariada, 1 sem. 2019 ## Juan Carlos Castillo & Alejandro Plaza ## *Sesión 4*: Regresión simple 2 --- class: inverse, bottom, left # **Contenidos** ## 1. Repaso de sesión anterior ## 2. Ajuste y residuos ## 3. Correlación y Regresión --- class: inverse, middle, center # 1. Repaso sesión anterior --- # Idea de distribución condicional .center[] ??? Ejemplo para los sujetos con 1 en X hay 3 valores de Y: 2, 3 y 4. Por lo tanto, la media condicional de Y dado X=1 es 3 --- # La recta de regresión La (co) variación general de Y respecto a X se puede expresar en una ecuación de la recta = modelo de regresión .center[] Para obtener la “mejor recta” se utiliza la estimación de mínimos cuadrados (EMC, o **OLS** – Ordinary Least Squares), que minimiza la suma de los cuadrados de las distancias entre las observaciones y la recta en el eje vertical --- # Componentes de la ecuación de la recta de regresión `$$\widehat{Y}=b_{0} +b_{1}X$$` Donde - `\(\widehat{Y}\)` es el valor estimado de `\(Y\)` - `\(b_{0}\)` es el intercepto de la recta (el valor de Y cuando X es 0) - `\(b_{1}\)` es el coeficiente de regresión, que nos dice cuánto aumenta Y por cada punto que aumenta X --- # Estimación de los coeficientes de la ecuación por mínimos cuadrados ordinarios `$$b_{1}=\frac{Cov(XY)}{VarX}$$` `$$b_{1}=\frac{\frac{\sum_{i=1}^{n}(x_i - \bar{x})(y_i - \bar{y})} {n-1}}{\frac{\sum_{i=1}^{n}(x_i - \bar{x})(x_i - \bar{x})} {n-1}}$$` Y simplificando `$$b_{1}=\frac{\sum_{i=1}^{n}(x_i - \bar{x})(y_i - \bar{y})} {\sum_{i=1}^{n}(x_i - \bar{x})(x_i - \bar{x})}$$` Luego despejando el valor de `\(b_{0}\)` `$$b_{0}=\bar{Y}-b_{1}\bar{X}$$` --- # Resumiendo: Modelo de regresión (simple) .center[] - Se estima mediante el método de mínimos cuadrados ordinarios (OLS) - Permite estimar el valor de una variable ( `\(\widehat{Y}\)` ) a partir del valor conocido de otra variable ( `\(X\)` ) - La estimación se expresa en el coeficiente de regresión `\(b_{1}\)`, también llamado "beta" o pendiente - Este coeficiente se interpreta de la siguiente manera: Por cada unidad que aumenta X, Y aumenta en `\(b_{1}\)` unidades --- # Modelos y pendientes .center[] --- # Pregunta Si tenemos - Y = ingreso al egresar de la universidad - X = puntaje PSU `$$Ingreso=200.000+400(puntajePSU)$$` -- 1 - ¿Cuál es el valor estimado de Ingreso para un puntaje PSU de 500? -- - 400.000 -- 2 - ¿Cuál es el valor estimado de Ingreso para un puntaje (hipotético) de PSU=0? -- - 200.000 --- class: inverse, middle, center # PREGUNTAS --- class: inverse, middle, center # 2. Ajuste y residuos --- # Bondad de Ajuste: suma de cuadrados y R2 .center[## ¿Qué tan bueno es nuestro modelo?] -- .center[] ??? A partir del método de Mínimos Cuadrador Ordinarios,obtenemos una recta que describe un conjunto de datos minimizando las diferencias entre el modelo ajustado a los datos y los datos mismos. No obstante, incluso cuando se ajusta el mejor modelo puede existir cierta imprecisión, la cual es representada por las diferencias entre los datos observados y los valores predichos por la recta de regresión. La imprecisión implica evaluar la **Bondad de Ajuste** y se evalua a partir del estadístico `\(R^2\)`. --- # Observados, estimados & residuos .center[] El ajuste se relaciona con la diferencia entre los puntajes observados ( `\(Y\)` ) y el puntaje estimado ( `\(\widehat{Y}\)` ) --- # Ajuste y Residuos .pull-left[ .small[ ``` ## id juegos puntos estimado residuo ## 1 1 0 2 2.5 -0.5 ## 2 2 0 3 2.5 0.5 ## 3 3 1 2 3.0 -1.0 ## 4 4 1 3 3.0 0.0 ## 5 5 1 4 3.0 1.0 ## 6 6 2 2 3.5 -1.5 ## 7 7 2 3 3.5 -0.5 ## 8 8 2 4 3.5 0.5 ## 9 9 2 5 3.5 1.5 ## 10 10 3 2 4.0 -2.0 ## 11 11 3 3 4.0 -1.0 ## 12 12 3 4 4.0 0.0 ## 13 13 3 5 4.0 1.0 ## 14 14 3 6 4.0 2.0 ## 15 15 4 3 4.5 -1.5 ## 16 16 4 4 4.5 -0.5 ## 17 17 4 5 4.5 0.5 ## 18 18 4 6 4.5 1.5 ## 19 19 5 4 5.0 -1.0 ## 20 20 5 5 5.0 0.0 ## 21 21 5 6 5.0 1.0 ## 22 22 6 5 5.5 -0.5 ## 23 23 6 6 5.5 0.5 ``` ] ] -- .pull-right[ `$$\widehat{Y}=b_{0} +b_{1}X$$` `$$Y=b_{0}+b_{1}X+e$$` Donde - X = puntaje observado juegos - Y = puntaje observado puntos - `\(\widehat{Y}\)` = puntaje estimado puntos - `\(b_{0}\)`= intercepto - `\(b_{1}\)`= coeficiente de regresión de juegos - `\(e\)` = residuo ] --- # Descomposición de Y ### - Tres piezas de información relevante: `\(Y\)` = Valor observado de Y `\(\widehat{Y}\)` = estimación de Y a partir de X `\(\bar{Y}\)` = promedio de Y --- # Descomponiendo Y .center[] -- `$$Y=\bar{Y}+(Y-\widehat{Y})+(\widehat{Y}-\bar{Y})$$` -- $$ \Sigma(y_i - \bar{y})^2=\Sigma (\bar{y}-\hat{y}_i)^2 + \Sigma(y_i-\hat{y}_i)^2 $$ --- # Descomponiendo Y Conceptualmente: `$$SS_{tot}=SS_{reg} + SS_{error}$$`  --- # Varianza explicada Por lo tanto: `$$SS_{tot}=SS_{reg} + SS_{error}$$` -- `$$\frac{SS_{tot}}{SS_{tot}}=\frac{SS_{reg}}{SS_{tot}} + \frac{SS_{error}}{SS_{tot}}$$` -- `$$1=\frac{SS_{reg}}{SS_{tot}}+\frac{SS_{error}}{SS_{tot}}$$` `$$\frac{SS_{reg}}{SS_{tot}}= 1- \frac{SS_{error}}{SS_{tot}}=R^2$$` <br> ### .center[¿Qué quiere decir esto?] --- # Varianza explicada I .center[] - Parte de la variación de Y (ej: ingreso) se asocia a la variación de X (ej: educación) --- # Varianza explicada II .center[] - Un porcentaje de la variación de Y puede ser asociado a la variación de X: `\(R^2\)` --- # Volviendo al ejemplo: Puntos en partido .pull-left[ .small[ ``` ## id juegos puntos estimado residuo ## 1 1 0 2 2.5 -0.5 ## 2 2 0 3 2.5 0.5 ## 3 3 1 2 3.0 -1.0 ## 4 4 1 3 3.0 0.0 ## 5 5 1 4 3.0 1.0 ## 6 6 2 2 3.5 -1.5 ## 7 7 2 3 3.5 -0.5 ## 8 8 2 4 3.5 0.5 ## 9 9 2 5 3.5 1.5 ## 10 10 3 2 4.0 -2.0 ## 11 11 3 3 4.0 -1.0 ## 12 12 3 4 4.0 0.0 ## 13 13 3 5 4.0 1.0 ## 14 14 3 6 4.0 2.0 ## 15 15 4 3 4.5 -1.5 ## 16 16 4 4 4.5 -0.5 ## 17 17 4 5 4.5 0.5 ## 18 18 4 6 4.5 1.5 ## 19 19 5 4 5.0 -1.0 ## 20 20 5 5 5.0 0.0 ## 21 21 5 6 5.0 1.0 ## 22 22 6 5 5.5 -0.5 ## 23 23 6 6 5.5 0.5 ``` ] ] -- .small[ .pull-right[ ```r ss_tot<- sum((datos$puntos- mean(datos$puntos))^2); ss_tot ``` ``` ## [1] 42 ``` ```r ss_reg<- sum((datos$estimado - mean(datos$puntos))^2); ss_reg ``` ``` ## [1] 17 ``` ```r ss_reg/ss_tot ``` ``` ## [1] 0.4047619 ``` ```r #Directamente desde el modelo estimado summary(lm(puntos~juegos, data=datos))$r.squared ``` ``` ## [1] 0.4047619 ``` **Un 40% de la varianza en los puntos obtenidos en el juego se relaciona con la (varianza de) experiencia previa en juegos** ] ] --- class:inverse, middle,center # PREGUNTAS --- class:inverse, middle,center # 3. Correlación y regresión --- ## Equivalencias en regresión y correlación -- .left-column[ ### _R2_ y _r_ de Pearson ] .right-column[ Correlación (Pearson) entre juegos y puntos ( `\(r\)` ) ```r cor(datos$juegos,datos$puntos) ``` ``` ## [1] 0.636209 ``` -- Correlación entre juegos y puntos **al cuadrado** ```r (cor(datos$juegos,datos$puntos))^2 ``` ``` ## [1] 0.4047619 ``` Es decir: `\(r^2\)` es `\(R^2\)` ] --- ## Equivalencias en regresión y correlación .left-column[ ### _R2_ y _r_ de Pearson ### Regresión estandarizada ] .right-column[ - Puntaje estandarizado (o `\(Z\)`): expresado en desviaciones estándar - Regresión estandarizada: con puntajes estandarizados `$$Z_{X_{i}}=\frac{X_{i}-\bar{X}}{s_{X}};Z_{Y_{i}}=\frac{Y_{i}-\bar{Y}}{s_{Y}}$$` ```r attach(datos) Xpuntos_Z=(puntos-(mean(puntos)))/sd(puntos) Yjuegos_Z=(juegos-(mean(juegos)))/sd(juegos) lm(Yjuegos_Z ~ Xpuntos_Z)$coefficients ``` ``` ## (Intercept) Xpuntos_Z ## 0.000000 0.636209 ``` - `\(b_1\)` estandarizado es equivalente al coeficiente de correlación ] --- ## Diferencias en regresión y correlación .left-column[ ### Intercambio ] .right-column[ - La correlación entre X e Y es la misma que entre Y e X - La regresión entre X e Y **no** es la misma que entre Y e X .small[ ```r cor(juegos,puntos) ``` ``` ## [1] 0.636209 ``` ```r cor(puntos,juegos) ``` ``` ## [1] 0.636209 ``` ```r lm(puntos~juegos)$coefficients ``` ``` ## (Intercept) juegos ## 2.5 0.5 ``` ```r lm(juegos~puntos)$coefficients ``` ``` ## (Intercept) puntos ## -0.2380952 0.8095238 ``` ] ] --- ## Diferencias en regresión y correlación .left-column[ ### Intercambio ### Dependencia de escala ] .right-column[ - Correlación es libre de la escala, regresión depende de la escala - Ejemplo: si se investiga relación peso / edad, si cambia la escala de medición del peso, la correlación es la misma pero la regresión es diferente. ] --- ## Diferencias en regresión y correlación .left-column[ ### Intercambio ### Dependencia de escala ### Rango ] .right-column[ - La correlación aumenta con el rango de medición de las variables, no así la regresión  - Ej: Mismo beta, pero mayor correlación en A que en B ] --- class: inverse, middle, center # PREGUNTAS --- class: bottom, left .right[] <br> <br> <br> <br> <br> <br> <br> # Estadística multivariada, 1 sem. 2019 ## Juan Carlos Castillo & Alejandro Plaza ## **Sesión 3**: Regresión simple 1